데이터센터(DC)의 근간을 이루는 IT장비 성능이 하루가 다르게 발전하면서 DC 구조 및 쿨링시스템 또한 해마다 급변하며 진화하고 있다.

최근 개최된 추계 DC 컨퍼런스에서 모기진 한국휴렛팩커드 상무는 “DC 에너지효율화 핵심은 설비지만 그럼에도 불구하고 DC의 출발점은 IT”라며 “IT를 구동하기 위해 수많은 장비들이 시스템을 이루는 것이므로 최근 IT 트렌드를 파악해야 최적의 쿨링설비구조 및 체계를 확보할 수 있다”고 밝혔다.

이어 “최근 진행된 IT 패러다임 변화는 서비스, DC로 이어지는 연속적 패러다임 변화를 불러올 것으로 예측된다”라며 “현재 다수 구축 중인 클라우드DC는 앞으로의 DC와 형태가 매우 다르다”고 지적했다. 최근 진행 중인 DC 형태변화의 출발점은 IT부하다. 과거 IDC(인터넷DC)환경에서는 메인프레임 환경에서 랙당 0.5~1kW 수준에 불과했지만 5년 전 CDC(클라우드DC)에서는 AWS(아마존웹서비스)가 랙당 8.4kW를 요구했다. MS(마이크로소프트)도 6kW 수준을 요구하다 최근에는 12.5kW, 올해 15kW 이상을 요구하고 있다. AWS는 미국에서 25~30kW를 요구하고 있다.

AWS, MS 등 글로벌 CSP들의 국내 진출이 예고된 가운데 이러한 IT부하 증가 추세는 조만간 우리나라에도 전해질 전망이다.

DC를 구성하는 필수요소는 △서버(데이터처리) △스토리지(데이터저장) △랙(서버‧네트워크 장비설치용 캐비닛) △네트워크(DC 내 서버를 통신망에 연결) △PDU(전력분배장치) △UPS(비상전력공급장치) △배터리(정전 시 전력공급을 위한 에너지저장) △발전기(정전 시 자가발전을 위한 장비) △수배전(외부 전원을 받아 내부 DC에 분배) △STS/ATS(다중전원 소스 중 가용방향으로 연결) △항온항습기(DC 온‧습도 유지) △냉동기(냉수생산 후 항온항습기에 공급) △냉각탑(냉동기 발생열을 식히는 장치) △보안방재(CCTV‧소화가스 등 보안 및 방재장비) △DCIM/EMS(DC 전체 운영 모니터링) △사무실(DC 운영‧관리자용 사무공간) 등이다.

이미 구시대 DC, 전통적 DC로 물러나고 있는 CDC의 설계동향을 살펴보면 UPS는 지하에서 지상으로, 층 하중은 1.2~1.5t/㎡로, 액세스 플로어가 없는 형태로, 항온항습기는 공급온도가 24~27℃으로, PUE는 1.3 이하로 디자인되고 있다.

최근들어 AI 및 클라우드, 특히 챗GPT 등 LLM(Large Language Model: 대형언어모델)은 매우 큰 IT성능을 요구하고 있으며 이에 따라 고부하‧고집적‧고발열이 빠른 속도로 진행되고 있다.

산업이 AI로 흐르면서 IT가 변화하는 것이다. AI는 빅데이터가 없으면 무용지물이며 빅데이터 처리에는 복잡한 연산이 가능한 CPU보다 단순계산을 빠르게 처리할 수 있는 GPU가 적합하다. GPU는 발열이 매우 큰 특성이 있으며 최근 NVIDIA(엔비디아) 주력인 H100모델은 칩 하나당 400W를 소모한다. H100에는 칩 8개가 탑재되며 디스크, 팬 등을 더하면 서버당 6~7kW를 소모한다. 통상 랙당 서버 6개가 탑재되므로 42kW가 필요하다.

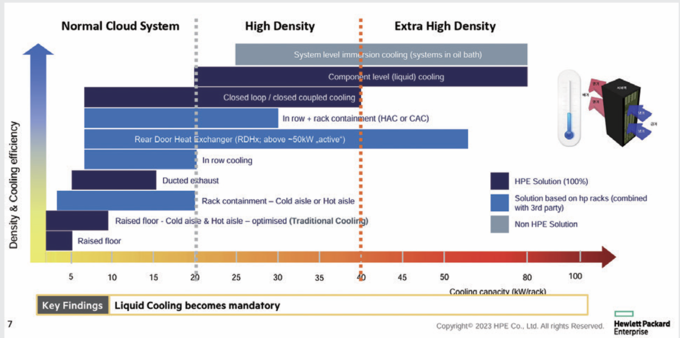

이에 따라 랙당 40kW 이상의 부하설계가 요구되며 랙당 100kW까지도 검토하는 경우가 있다. 특히 PUE는 1.2 이하를 달성해야 높이 평가받을 정도로 에너지효율 기준도 높아지고 있어 새로운 쿨링시스템이 요구된다.

“리퀴드쿨링, 향후 대세 확정적”

쿨링방식은 공랭식과 수냉식을 검토할 수 있다. HP가 공랭식으로 구축한 AI DC의 경우 전산실 하나를 2층 구조로 하는 더블덱 구조를 적용해 하층에 항온항습기를 다량 배치하고 상층에 IT 장비를 설치한다. 이를 바탕으로 빠른 공기흡입과 흐름을 갖는 Close Coupled 형태로 구성할 경우 40kW까지 쿨링이 가능하다.

그 이상의 부하에서는 수냉식이 유일한 대안이다. 비열이 공기의 100배가 넘는 액체를 이용하며 공급온도가 45℃로도 가능하므로 이 경우 냉동기 없이 시스템을 구성할 수 있다. 수냉식은 DLC(Direct-contact Liquid Cooling)과 액침냉각(Immersion Cooling)으로 구분된다. DLC는 각 칩에 열교환기를 두고 파이프를 통해 액체를 통과시키는 방식이며 액침냉각은 수조에 용액을 채우고 서버를 담그는 방식이다.

모기진 상무는 “DLC를 채택할 경우 PUE는 1.2 이하 달성이 가능하며 액침냉각을 선택할 경우 PUE는 1.1 이하가 가능하다”라며 “수냉식을 이용하면 냉동기가 제외되므로 투자비가 절약되며 OPEX 역시 상당히 절감되므로 향후 DC시장은 수냉식, 리퀴드 쿨링으로 구축될 수밖에 없을 것”이라고 예측했다.

최근 개최된 추계 DC 컨퍼런스에서 모기진 한국휴렛팩커드 상무는 “DC 에너지효율화 핵심은 설비지만 그럼에도 불구하고 DC의 출발점은 IT”라며 “IT를 구동하기 위해 수많은 장비들이 시스템을 이루는 것이므로 최근 IT 트렌드를 파악해야 최적의 쿨링설비구조 및 체계를 확보할 수 있다”고 밝혔다.

최근 개최된 추계 DC 컨퍼런스에서 모기진 한국휴렛팩커드 상무는 “DC 에너지효율화 핵심은 설비지만 그럼에도 불구하고 DC의 출발점은 IT”라며 “IT를 구동하기 위해 수많은 장비들이 시스템을 이루는 것이므로 최근 IT 트렌드를 파악해야 최적의 쿨링설비구조 및 체계를 확보할 수 있다”고 밝혔다.